作者:何宗諭 / 臺灣大學計算機及資訊網路中心程式設計組幹事

第22屆人工智慧與應用研討會(Technologies and Applications of Artificial Intelligence,簡稱TAAI 2017)於本月初圓滿落幕,TAAI邀請了國內外知名人工智慧的專家與學者共襄盛舉,TAAI除了研究成果發表,也是學界與業界的交流平台、理論與應用的整合。本會議是臺灣在人工智慧領域中非常重要的一個學術研討會,不管是想瞭解人工智慧應用的入門者,或是已鑽研多年的專家學者,都值得參與,錯過本次會議的人也不用可惜,本報導快速帶大家回顧一下今年會議的重點。

圖一、TAAI 2017 in Taiwan

會議介紹

本會議分為四個部分:(1)人工智慧的Tutorial:協助聽眾從入門到進階的介紹,涵蓋近年來相當熱門的金融科技(FinTech)與自然語言處理(Natural Language Processing);(2)論文的發表:涵蓋機器學習、深度學習、以及各式各樣的演算法等理論與應用的成果發表,詳細發表成果可以參考TAAI官網;(3)邀請國內外重量級學者Keynote演講以及知名業界領袖演講,讓我們對人工智慧的發展有更深入的理解;(4)以及由業界專家所帶來的Panel討論。

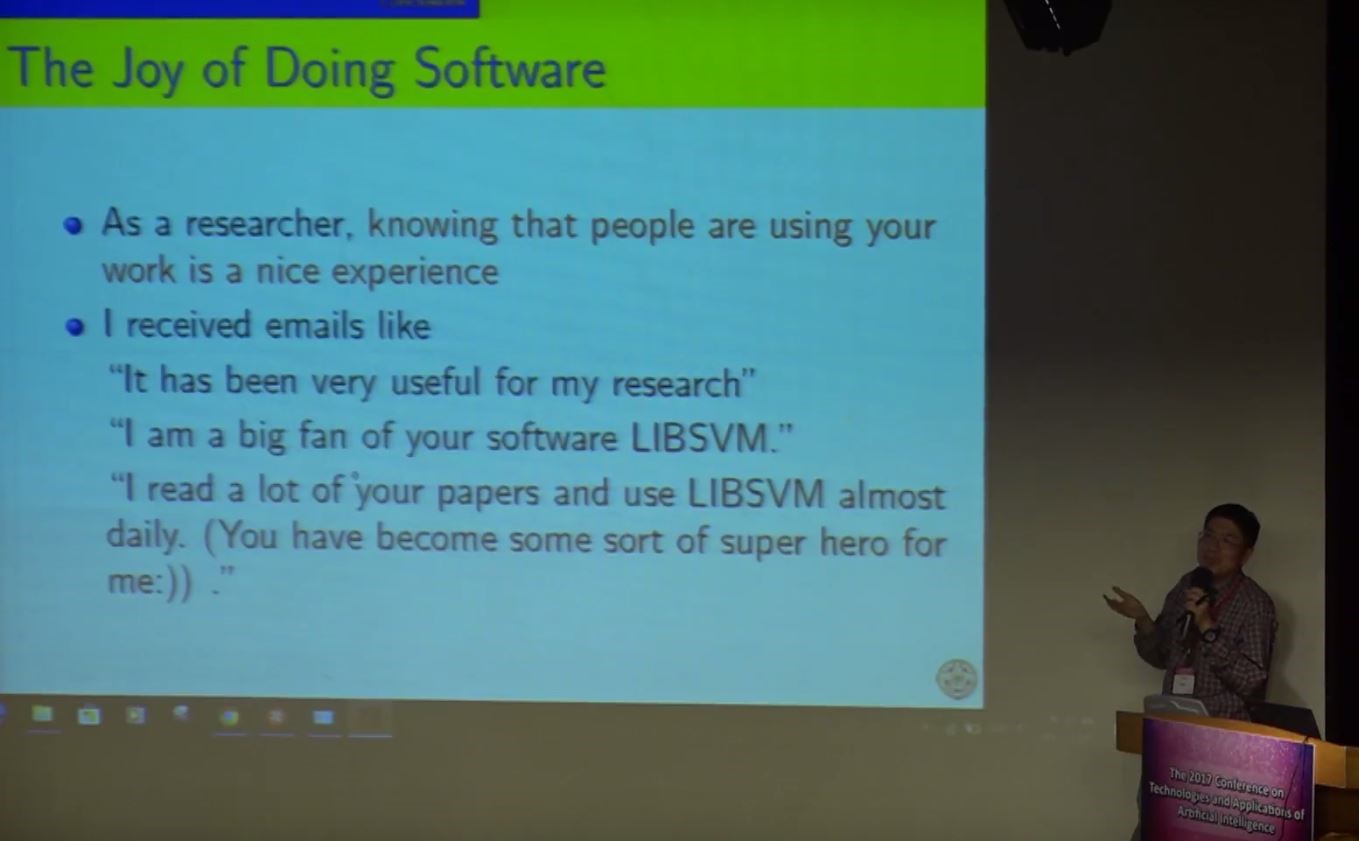

Keynote演講,演講者:林智仁教授

題目:Lessons learned from developing machine learning algorithms and systems

林智仁教授在機器學習與資料探勘領域上有卓越的研究,這是一個很難得的機會,能在公開場合聽到他分享的研究成果。他們團隊所開發的知名開源軟體LIBSVM,已在國際上被廣泛地應用在各大學術成果上,是非常不容易,也呼應臺大許永真教授在今年的演講中提到的開源文化,談到臺灣學界在開源文化遠不及國外,造成花大量時間獨立開發成果,卻因為不開源而無法整合性的合作,相當可惜。所以LIBSVM的開源,不只是技術的交流,也是開源文化的先驅,也因此造就臺大多個團隊拿到不少ACM競賽冠軍。

圖二、Motivation of developing LIBSVM

林智仁教授介紹了他們團隊兩個知名開源軟體-LIBSVM和LIBLINEAR,前者用於SVM(supported vector machine),後者用於Large Linear Classification應用。

LIBSVM至今已經被引用3萬4千次以上,其中Citeseer顯示LIBSVM為電腦科學領域中最多被引用的10個研究之一。回顧過去,林教授談到發展開源軟體的動機,起因於許多研究並未詳盡說明細節步驟,導致大眾很難重現其原實驗結果,也因此失去了相互交流的機會,因此林教授認為一個學者應致力於將研究回饋給大眾社群,對於大眾學者的期許,不應該只是純粹為了發表論文,而是必須回到研究的初衷,也就是解決問題本身。開發開源軟體的另一個關鍵在於並非人人皆是機器學習或是人工智慧的專家,在大數據的年代,數據的需求大幅增加(註:一個優秀的人工智慧成果是必須來自於大量資料的模型訓練),也因此人才必須跨領域的合作,一個好的點子甚至贏過對演算法實作的理解,而開源軟體正是幫助不同領域的專家將好的想法,最快付諸實現的工具。

筆者想到在2015年Google將TensorFlow成果開源,其目地是希望回饋給社群,也期望能從社群的回應中幫助軟體的完善。如同在2000年以前,林教授就已經致力於機器學習的開源,這給臺灣未來想發展人工智慧軟體,是一個很好的啟示。

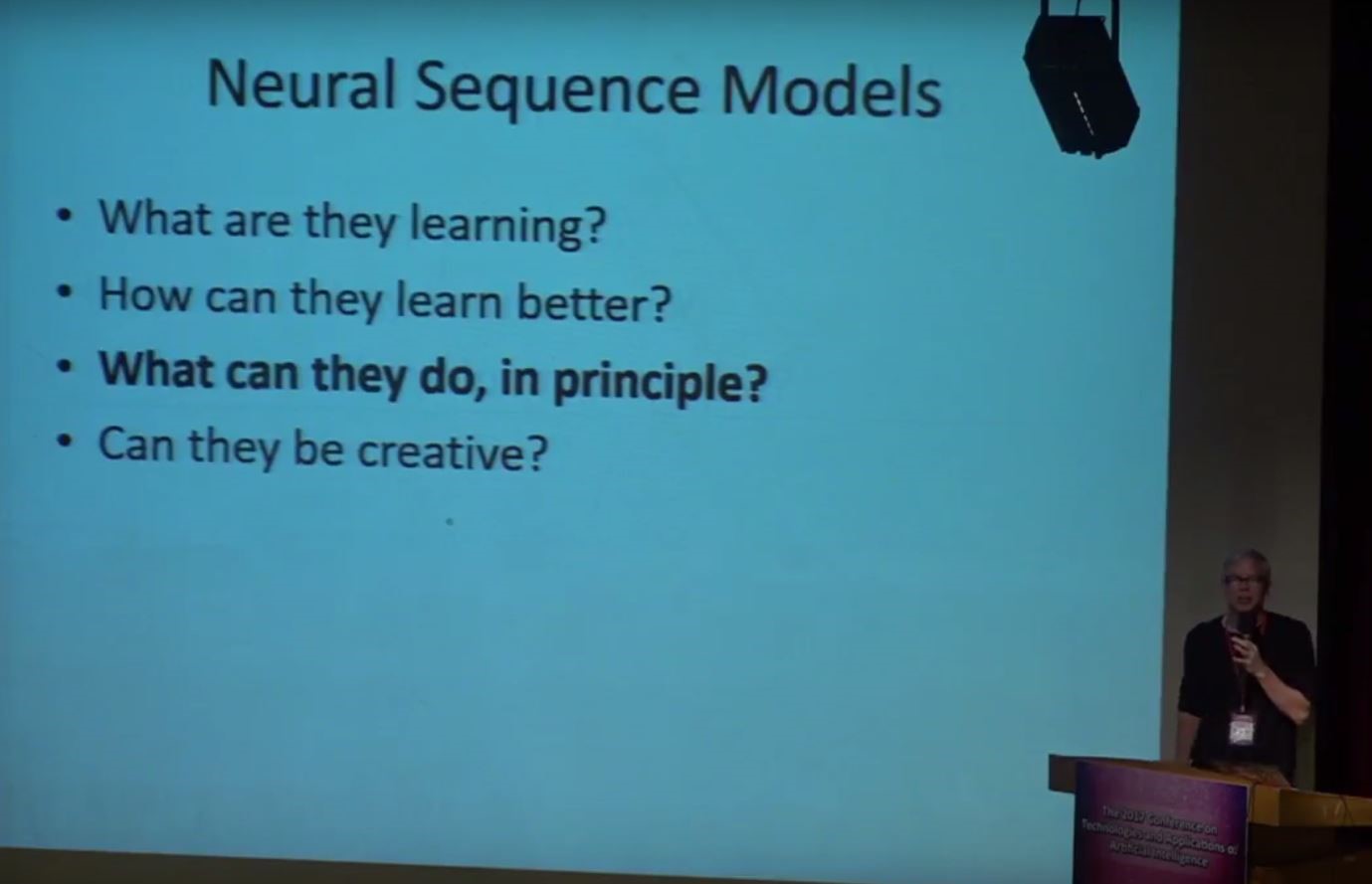

Keynote演講,演講者:Professor Kevin Knight

題目:What is Neural Machine Translation Learning?

第二場Keynote邀請到國外研究Natural Language Processing(自然語言處理NLP)的專家學者來介紹他在NLP上的研究心得與成果。近年來因為網路全球化的影響,人們對於語言翻譯的需求大量增加,也讓學界與產業更致力於發展更精確的演算法,其中跟傳統機器學習模型不一樣的地方在於,語言是序列組成,機器不但需要瞭解每個單字的意義,更必須要依照前後字句來解讀整句話的意義,因此一般在處理這類問題,都會使用遞歸神經網絡(Recursive Neural Network,簡稱RNN)的架構來處理,RNN其實跟我們熟知的類神經網路相似,最大的差別是將多個類神經網路序列串接成RNN。

圖三、Neural Sequence Models

Professor Knight簡單介紹了機率模型的概念,說明如何用條件機率來描述單字與單字之間的關係,接著再用RNN的架構去訓練學習,並推估原始的機率模型。在RNN為成為主流應用以前,早在1960年代以來就有不少架構在處理語言翻譯的問題,像是String Automata和Tree Automata。因此我們更想瞭解RNN是否提高更準確的翻譯品質,近年來有幾篇關於機器翻譯蠻重要的論文,可以參考這兩篇Sequence to sequence learning with neural networks(Sutskever et al. in NIPS, 2014),Neural machine translation by jointly learning to align and translate (Bahdanau et al. in ICLR,2015)。

RNN雖然在處理語言翻譯上有不錯的成果,但是在應用層面上RNN須要大量的資料範本來訓練模型,Professor Knight舉了一個簡單的例子,假若提供一百萬筆翻譯文本(例如烏茲別克語轉成英語),會發現RNN在準確度上不如Syntax-based的方法,這也是為什麼類神經網路是很早提出的演算法,過去卻因為資料量不夠,而無法提高精確度。近年來透過深度學習(加深類神經網路層數)以及大數據的資料,因此在文字翻譯上有很大的進步,但Professor Knight認為在機器翻譯這領域,我們其實還在早期階段,未來還有很多應用發展待我們研究,比如說機器創意這塊,我們如何讓機器自動翻譯並且能夠創作像是詩、短篇文章、短篇小說,甚至是類型小說的創造,仍有待我們去研究。

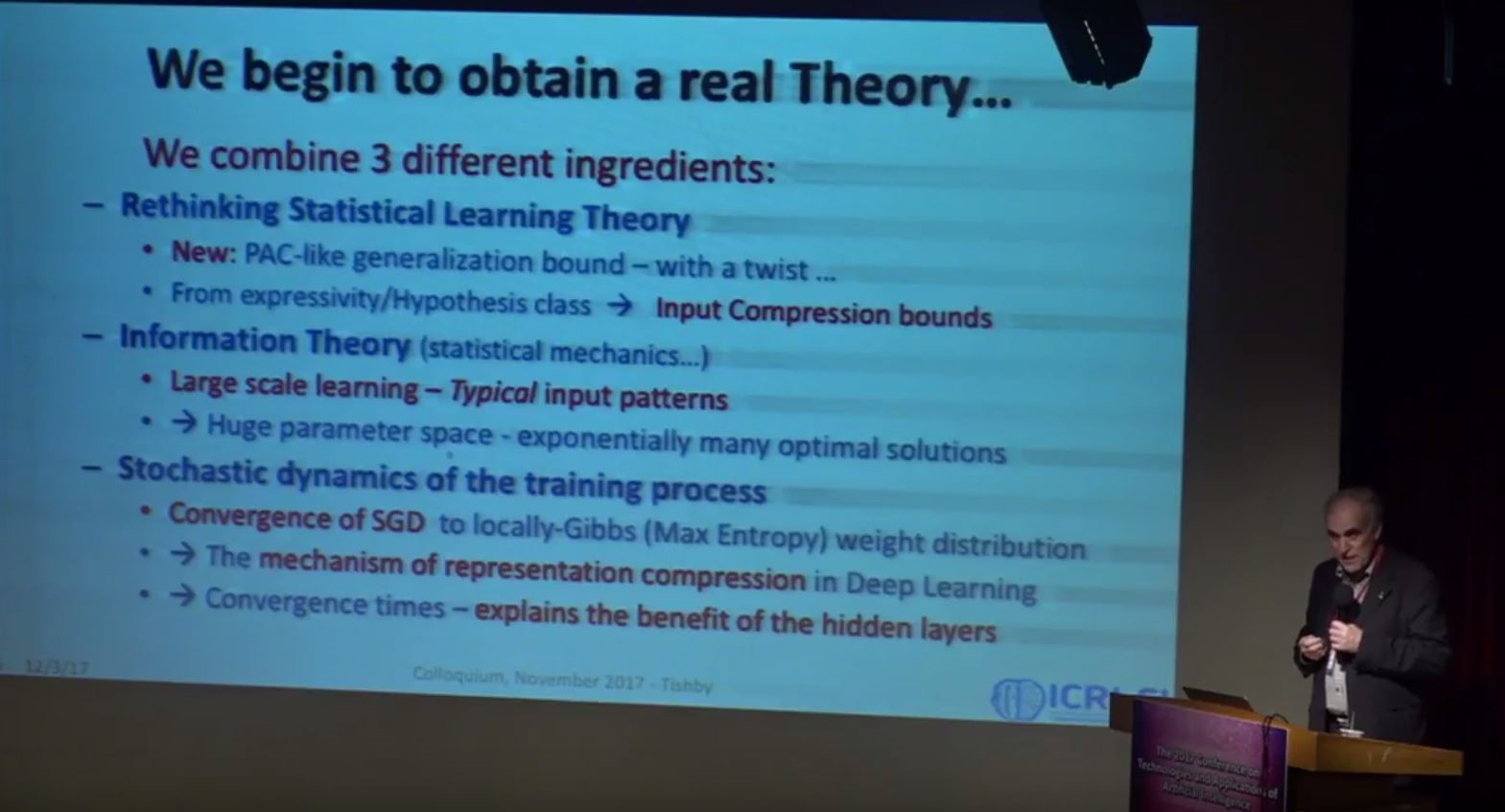

Keynote演講,演講者:Professor NAFTALI (TALI) TISHBY

題目:Information Theory of Deep Learning

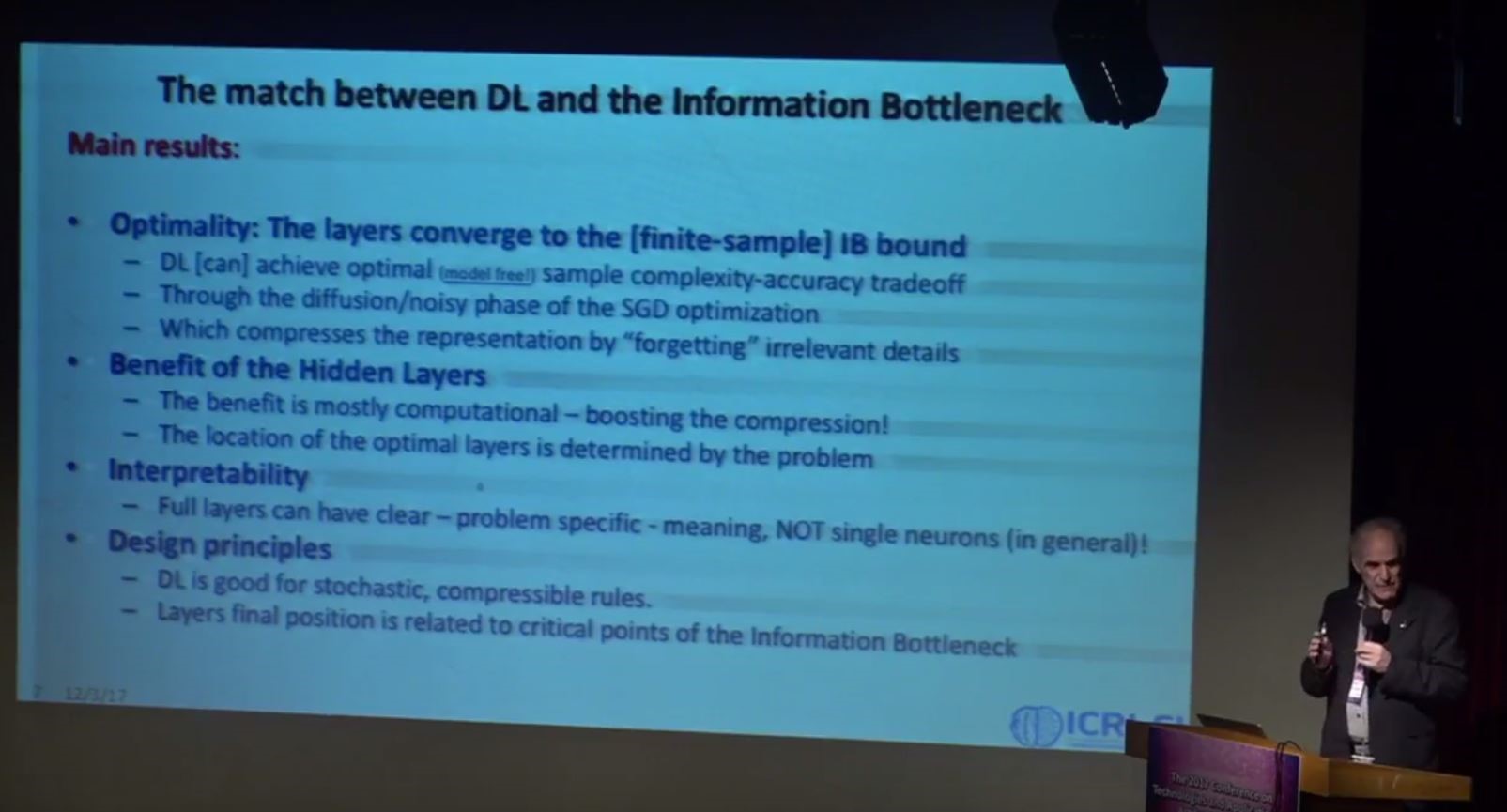

近年來深度學習(Deep Learning)在人工智慧領域中刮起了一片旋風,因為深度學習在很多傳統機器學習的問題上,都有顯著的進步,甚至不太需要瞭解深度學習原理,只要透過增加神經元的方式都有非常好的結果。因此也有一部份的學者認為,深度學習太過重視應用結果而缺乏理論基礎,因為缺乏理論基礎,會讓我們懷疑這樣的成果是否只是錯誤嘗試的結果。但事實上,在深度學習領域中,仍有不少學者致力於理論的研究,今天邀請的Professor Tishby,就是研究這塊理論的專家,他從自身消息理論(Information Theory)的背景來探討深度學習的理論模型。

圖四、The Based Theory

Professor Tishby提到有三個主要的研究基礎可以幫助我們理解深度學習的理論(1)統計學習理論,(2)消息理論,(3)Stochastic Dynamics假定,以上這些理論都是在80至90年代發展出來。比方說我們假定已知的問題,其背後有一個機率分布,但我們不可能知道,所以利用PAC的概念去取樣,我們可以推估此機率模型的上界範圍;當我們面對的是一個巨量的線性運算式(大部份的深度學習的收斂,需處理大量的矩陣乘法運算),消息理論幫助我們分析輸入模式,刪除多餘的資料(即不討論Worst-Case的問題)。或者使用entropy或是mutual information這類的統計工具,幫助量化狀態。

我們大眾更有興趣的是,想知道為何增加類神經網路,就能提高解決問題的準確度,Professor Tishby以統計與消息理論為基礎,跟我們解釋了hidden layers對於類神經網路帶來的影響與好處。並且解釋在類神經網路下,能否找到最佳解(從演算法的角度來看,也就是沒有其它的方法可以超過這個演算法)。若有興趣的讀者可以參考其論文Deep Learning and the Information Bottleneck Principle(https://arxiv.org/abs/1503.02406)

圖五、Deep Learning result

總結

本次TAAI會議真的是機會難得,可以邀請國內外知名學者來演講,從專家學者的研究方向,其實也給了我們研究人工智慧最好的建議,林教授給了我們一個很好的思考方向,或許開源文化是一個相當好的研究動機與進步;Professor Knight從語言分析的角度探討RNN為何能成功應用在機器翻譯上,以及未來的延伸應用;最後Professor Tishby以消息理論為基礎探討了深度學習的限界,以避免不必要的錯誤嘗試。礙於篇幅有限,本電子報僅針對Keynote演講重點整理,其它演講內容也相當有趣,但也只能割捨。若對於人工智慧有興趣,未來台大演講網編輯後製完成(https://speech.ntu.edu.tw/ntuspeech/),也會放上本次Keynote直播內容,甚至報名參加TAAI 2018的會議。

參考資料

[1] TAAI官網:https://www.csie.ntu.edu.tw/~taai2017/

[2] 個人與會記錄