作者:周秉誼 / Tomofun資深技術經理

OpenAI的ChatGPT服務是過去兩年間,在整個深度學習及人工智慧領域中的一個震撼彈,也令大語言模型成為全球科技產業及學術界的兵家必爭之地。除了ChatGPT-3.5及GPT-4,OpenAI也在2024年5月13日推出了GPT-4o版本,不只讓付費的使用者可以使用比GPT-4版本更強大的GPT-4o模型,也讓所有免費使用的使用者可以全面使用到最新最強大的模型。本文將簡介GPT-4o的功能和能力。

前言

OpenAI推出的ChatGPT相關服務,可稱得上是過去兩年間,在整個深度學習及人工智慧領域中的一個震撼彈,在2022年底ChatGPT問世之後,大語言模型(Large Language Model, LLM)成為全球科技產業及學術界的兵家必爭之地,從大語言模型的各種服務,到運行大語言模型的後端計算資源,都有突破性的發展,這些發展也讓過去相當困難的人工智慧功能變為現實,甚至成為人人都可取用的資源。在這些科技巨頭中,OpenAI還是扮演舉足輕重的角色,並且持續不斷推出更為強大的大語言模型服務,一再刷新人們對人工智慧的想像。2022年底一開始免費的ChatGPT-3.5,只能使用純文字的對話,隨後在2023年初推出付費的GPT-4版本,可以使用文字和圖片做為輸入,到2024年5月13日推出了GPT-4o版本,不只讓付費的使用者可以使用比GPT-4版本更強大的GPT-4o模型,也讓所有免費使用的使用者可以全面使用到最新最強大的模型。

GPT-4o新功能

2024年5月13日,OpenAI公佈了最新最強大的ChatGPT服務:GPT-4o,其中的o字母代表了全向(Omni),因為GPT-4o可以比先前任一版本的ChatGPT模型,提供了更加自然的人機互動——它能接受任何組合的文本(Text)、音訊(Audio)、圖像(Image)和影片(Video)作為輸入(Input),並生成任何組合的文本、音訊和圖像輸出。並且可以在短至232毫秒內對音訊輸入做出回應,平均回應時間為320毫秒,這與人類在對話中的反應時間相似。它在英文文本和編碼方面的性能與GPT-4 Turbo相當,並且在非英文語言的文本處理上有顯著改進,同時在API中速度更快且成本降低了50%。與現有模型相比,GPT-4o在視覺(Vision)和音訊理解方面尤為出色。

在GPT-4o之前,我們可以使用語音模式(Voice Mode)與ChatGPT對話,平均延遲時間為2.8秒(GPT-3.5)和5.4秒(GPT-4)。為了讓純文字的大語言模型實現這一點,語音模式使用了三個獨立的模型:一個簡單的模型將語音音訊轉錄為文本,GPT-3.5或GPT-4模型接收文本並產出相對應的文字回應,然後第三個簡單模型將文本轉換回語音音訊。這個過程意味著主要的智慧來源——GPT-4會損失大量的資訊,因為這樣一來就不能直接觀察語氣、多個講話者或背景噪音,也不能輸出笑聲、唱歌或表達情感。

有了GPT-4o,OpenAI訓練了一個全新的End-to-End模型,涵蓋文本、視覺和音訊,這意味著所有輸入和輸出都由同一個深度學習的神經網路進行處理。由於GPT-4o是OpenAI第一個結合所有這些模態的模型,OpenAI也在探索模型能夠做什麼及其局限性,因此提供了各種使用情境的範例方便大家了解GPT-4o的能力,包括視覺敘事(Visual Narrative)、電影海報生成(Movie Poster Creation)、角色設計(Character design)、詩意文字排版設計(Poetic Typography)、紀念幣(commemorative coin)設計、卡通化照片(Photo to Caricature)、3D物件生成、多人的會議記錄(Meeting notes)等等。由這些範例可以了解GPT-4o的多模態(Multimodality)能力比起GPT-4又更為進步,帶來更多的可能性。

圖1. GPT-4o範例:角色設計 (from: https://openai.com/index/hello-gpt-4o/)

GPT-4o效能及其他能力

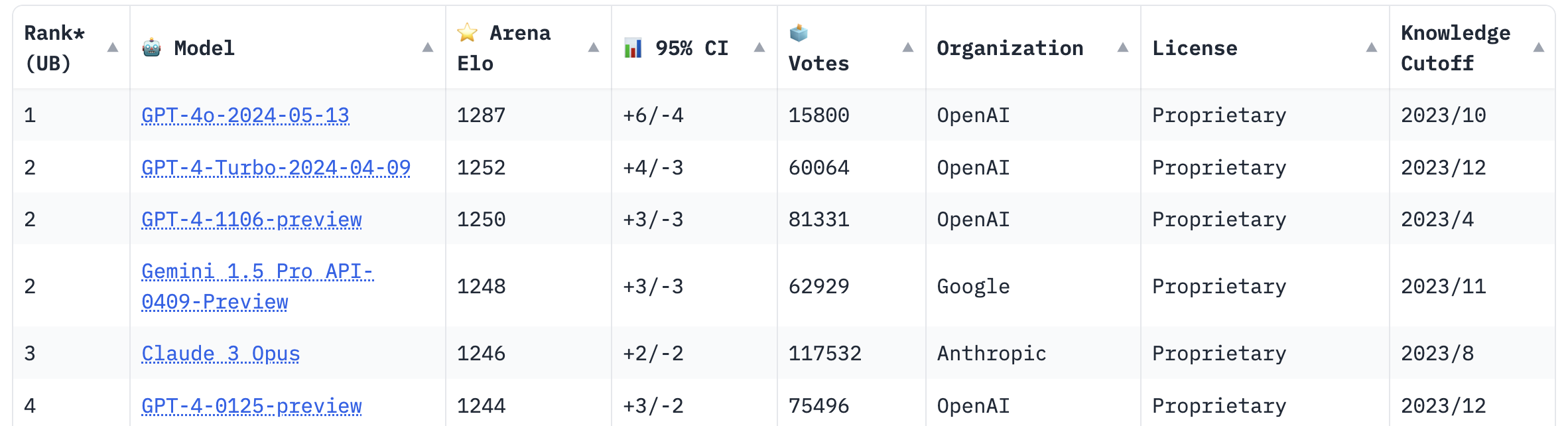

在模型效能方面,GPT-4o也有所突破,根據傳統基準測試,GPT-4o在文本、推理和程式設計方面達到了與GPT-4 Turbo相當的性能,同時在多語言(multilingual)、音訊和視覺能力方面創下了新高。以OpenAI提供的資料來看,在常識問題(general knowledge questions)類的0-shot推理鏈式多任務語言理解(CoT MMLU)的表現上創下了88.7%的新高分。在OpenAI提供的其他測試,包括自動語音識別(ASR)、語音翻譯(Audio translation)、多語言的問答等等項目中,GPT-4o都展現了比GPT-4更加的表現,甚至是目前最先進(State-of-the-art)的表現。在著名的LMSYS聊天機器人對戰排行榜(LMSYS Chatbot Arena Leaderboard)中,GPT-4o也在短短幾天中登上了排名第一的位置,小幅領先GPT-4。

除了模型效能之外,GPT-4o也針對不同語系的Token使用量進行最佳化。以往中文及其他非拉丁字母的語言在使用ChatGPT時,需要比拉丁字母語言更大量的Token使用,在GPT-4o中也大幅降低了Token的使用量。如中文、日文的Token使用量都降低了40%,俄文、韓文也降低了70%,對多種印度語言、如古加拉特語(Gujarati)、泰盧固語(Telugu)、坦米爾語(Tamil)、馬拉提語(Marathi)、印地語(Hindi)等,更能降低高達200%到300%的Token使用量。

針對多模態的大語言模型會再來的各種資訊安全風險,GPT-4o也經歷了來自70多位外部專家的廣泛外部紅隊測試(Red teaming),這些專家來自社會心理學、偏見與公正以及錯誤訊息等領域,旨在識別新加入模態帶來或增強的風險。OpenAI利用這些學習成果構建了新的安全措施,以提高與GPT-4o互動的安全性。

圖2.GPT-4o效能:LMSYS聊天機器人對戰排行榜

(from:https://chat.lmsys.org/?leaderboard)

結語

隨著GPT-4o服務向免費使用者推出後,這也是第一個將GPT-4級別模型推廣給大眾的嘗試,也意味著以往耗費大量計算資源的大語言模型,在包括模型架構、計算效能等各個技術層級都有所提升之後,能夠成為人人都可使用的工具。在這波將大語言模型朝向實際可用性方向發展的浪潮之下,也讓我們一起期待人工智慧及深度學習的疆界,將會被推動到什麼樣的境界。

參考資料

- https://openai.com/index/hello-gpt-4o/

- https://chat.lmsys.org/?leaderboard